자격증 준비하면서 내가 이해하기 편하게, 다시 보기 좋게 정리하는 빅데이터 분석기사의 내용 (자격증 상세 내용은 아래)

https://www.dataq.or.kr/www/sub/a_07.do

데이터자격시험

대용량의 데이터 집합으로부터 유용한 정보를 찾고 결과를 예측하기 위해 목적에 따라 분석기술과 방법론을 기반으로 정형/비정형 대용량 데이터를 구축, 탐색, 분석하고 시각화를 수행하는 업

www.dataq.or.kr

1과목인 빅데이터 분석 기획을 정리한 내용

데이터 품질 전략

- 정확성 : 데이터 사용 목적에 따라 데이터 정확성의 기준을 다르게 적용

- 완전성 : 필요한 데이터의 완전한 확보보다는 필요한 데이터를 식별하는 수준으로 적용 가능

- 적시성 : 소멸성이 강한 데이터에 대해 어느 정도의 품질 기준을 적용할 것인지 결정

- 일관성 : 같은 데이터라 할지라도 사용 목적에 따라 다라지는 데이터수집 기준 때문에 데이터 의미가 달라질 수 있음

※ 기출문제

→ 빅데이터의 주요 품질 지표로는 정확성, 완전성, 적시성, 일관성이 있다. (답: 1)

정형 데이터 품질 기준

- 완전성 : 필수 항목에 누락이 없어야 하는 성질

- 유일성 : 데이터 항목은 유일해야 하며 중복되어서는 안 되는 성질

- 유효성 : 데이터 항목은 정해진 데이터 유효범위 및 도메인을 충족해야 하는 성질

- 일관성 : 데이터가 지켜야 할 구조, 값, 표현되는 형태가 일관되게 정의되고, 서로 일치하는 성질

- 정확성 : 실제 존재하는 객체의 표현 값이 정확히 반영되어야 하는 성질

비정형 데이터 품질 기준

- 기능성 : 해당 콘텐츠가 특정 조건에서 사용될 때, 명시된 요구와 내재된 요구를 만족하는 기능을 제공하는 정도

- 신뢰성 : 해당 콘텐츠가 규정된 조건에서 사용될 때 규정된 신뢰 수준을 유지하거나 사용자로 하여금 오류를 방지할 수 있도록 하는 정도

- 사용성 : 해당 콘텐츠가 규정된 조건에서 사용될 때, 사용자에 의해 이해되고, 선호될 수 있게 하는 정도

- 효율성 : 해당 콘텐츠가 규정된 조건에서 사용되는 자원의 양에 따라 요구된 성능을 제공하는 정도

- 이식성 : 해당 콘텐츠가 다양한 환경과 상황에서 실행될 가능성

※ 기출문제

→ 비정형 데이터의 품질 기준으로는 기능성, 신뢰성, 사용성, 효율성, 이식성이 있으며, 정형 데이터의 품질기능으로는 완전성, 유일성, 유효성, 일관성, 정확성이 있다. (답 : 2)

메타데이터를 통한 품질 검증 기법

- 메타데이터 수집 : 테이블 정의서, 커럼정의서, 도메인 정의서, 데이터 사전, ERD, 관계 정의서를 통한 메타데이터 수집

- 수집된 메타데이터 분석 : 테이블, 칼럼, 관계목록을 대조하여 불일치 사항 분석

- 누락 값 분석 : NULL 값, 공백 값(’’), 숫자 ‘0’ 등 분포를 통해 누락 값 분석

- 값의 허용 범위 분석 : 칼럼의 속성값이 가져야 할 범위 내에 속성값이 있는지 여부가 아닌, 해당 속성의 도메인 유형에 따라 범위 결정

- 허용값 목록 분석 : 해당 칼럼의 허용값목록이나 집합에 포함되지 않는 값을 발견하는 절차

- 문자열 패턴 분석 : 칼럼 속성값의 특성이 문자열로 반복되는 모형을 정형화하여 해당 칼럼의 특성 파악

- 날짜 유형 분석 : DBMS 또는 시스템에서 제공하는 DATETIME 유형과 무자형 날짜 유형을 활용하여 날짜 유형 분석

- 유일 값 분석 : 업무적 의미에서 유일해야 하는 칼럼에 중복이 발생되었는지 확인하는 절차

- 구조 분석 : 잘못된 데이터 구조로 인해 데이터 값에서 일관되지 못하거나, 부정확한 값입 발견되는 현상을 파악하는 절차

데이터 프로파일링 절차

- 메타데이터 수집 및 분석 : 데이터베이스에 설계 반영된 물리 메타데이터 수집

- 대상 및 유형 선정 : 프로파일링 분석을 수행할 대상 업무 및 테이블 선정

- 프로파일링 수행 : 데이터 현상을 분석하여 누락 값, 비 유효 값, 무결성 위반 사항 등을 분석

- 프로파일링 결과 리뷰 : 프로파일링 결과를 취합하고, 업무 담당자에게 결과 리뷰 및 확정

- 프로파일링 결과 종합 : 확정된 프로파일링 결과물 취합

품질 검증 기준

- 복합성 : 빅데이터 수집 시스템에서 수집하는 데이터의 구조, 형식, 자료, 계층 측면에서 복잡성 기준을 정의

- 완전성 : 수집된 빅데이터 질이 충분하고 완전한지에 대한 품질 관리 기준을 정의

- 유용성 : 수집된 빅데이터 처리 용이성, 하드웨어 및 소프트웨어 제약 사항 관련 품질 관리 기준을 정의

- 시간적 요소 : 데이터 전달과 수집 사이의 소요 시간

- 일관성 : 수집된 빅데이터와 원천 소스가 연결되지 않는 비율 정도

- 타당성 : 수집된 빅데이터의 메타데이터를 분석한 방법이 안정성을 평가할 수 있는지 여부

- 정확성 : 자료의 값들이 허용범위 내에 존재하는지 여부

데이터 적재 도구

- 플루언티드(Fluented) : 트레저 데이터에서 개발된 크로스 플랫폼 오픈 소스 데이터 수집 소프트웨어

- 플럼(Flume) : 많은 양의 로그 데이터를 효율적으로 수집, 집계 및 이동하기 위해 이벤트와 에이전트를 활용하는 분산형 로그 수집 기술

- 스크라이브(Scribe) : 다수의 서버로부터 실시간으로 스트리밍 되는 로그 데이터를 수집하여 분산 시스템에 데이터를 저장하는 대용량 실시간 로그 수집 기술

- 로그스태시(Logstash) : 모든 로그 정보를 수집하여 하나의 저장소에 출력해 주는 시스템

※ 기출문제

→ 정형 데이터 체크리스트 항목으로는 테이블의 개수와 속성의 개수 및 데이터 타입의 일치 여부, 레코드 수 일치 여부가 될 수 있다. (답 : 1)

데이터 웨어하우스(DW)의 특징

사용자의 의사결정에 도움을 주기 위해 기간 시스템의 데이터베이스에 축적된 데이터를 공통 형식으로 변환해서 관리하는 데이터베이스

- 주제 지향적 : 기능이나 업무가 아닌 주제 중심적으로 구성

- 통합적 : 데이터의 일관성을 유지하면서 전사적 관점에서 하나로 통합

- 시 계열적 : 시간에 따른 변경을 항상 반영

- 비휘발적 : 적재가 완료되면 읽기 전용 형태의 스냅샷 형태로 존재

※ 기출문제

→ 데이터 웨어하우스의 특징은 주제지향성, 통합성, 시계열성, 비휘발성이다. (답 : 2)

→ 데이터 웨어하우스는 데이터 모델, ETL, ODS, DW Mea Data, OLAP, 데이터 마이닝, 분석 TOOL과 경영기반 솔루션으로 구성된다. (답 : 2)

데이터 마트(DM)의 특징

전사적으로 구축된 데이터 속의 특정 주제, 부서 중심으로 구축된 소규모 단위 주제의 데이터 웨어하우스

- DW 환경에서 정의된 접근계층으로, DW에서 데이터를 꺼내 사용자에게 제공

- DW에서 대부분을 차지하고, 특정 조직이나 팀에서 사용하는 것을 목적으로 함

데이터 레이크 특징

정형, 반정형, 비정형 데이터를 비롯한 모든 가공되지 않은 다양한 종류의 데이터를 저장할 수 있는 시스템 또는 중앙 집중식 데이터 저장소

- 정형 데이터는 RDBMS의 테이블에 저장

- 반정형 데이터는 CSV, XML, JSON에 저장

- 비정형 데이터는 바이너리 데이터 형태로 저장

- 저장할 때 스키마와 상관없이 저장 가능

빅데이터 저장 기술 분류

- 분산 파일 시스템 : 컴퓨터 네트워크를 통해 공유하는 여러 호스트 컴퓨터의 파일에 접근할 수 있게 하는 파일 시스템(GFS, HDFS, Lustre 등)

- 데이터베이스 클러스터 : 관계형 데이터베이스 관리 시스템으로 하나의 데이터베이스를 여러 개의 서버상에 구축하는 시스템(오라클 RAC, IBM DB2 ICE, MSSQL, MySQL 등)

- NoSQL : 전통적인 RDBMS와 다른 DBMS를 지칭하기 위한 용어로 데이터 저장에 고정된 테이블 스키마가 필요하지 않고 join 연산을 사용할 수 없음 (Hbase, SimpleDB, SSDS 등)

구글 파일 시스템(GFS)

- 클라이언트 : 파일에 대한 읽기·쓰기 동작을 요청하는 애플리케이션으로 파일 시스템 인터페이스와 유사한 자체 인터페이스 지원

- 마스터 : 단일 마스터 구조로 파일 시스템의 이름 공간, 파일과 청크의 매핑 정보, 각 청크가 저장된 청크 서버들의 위치정보 등에 해당하는 모든 메타데이터를 메모리상에서 관리

- 청크 서버 : 로컬 디스크에 청크를 저장하고, 클라이언트가 청크 입출력을 요청하면 청크서버가 처리함

하둡 분산 파일 시스템(HDFS)의 특징

수십 테라바이트 또는 페타바이트이상의 대용량 파일을 분산된 서버에 저장하고, 저장된 데이터를 빠르게 처리할 수 있게 하는 분산 파일 시스템

- 저사양의 다수 서버를 이용해 스토리지를 구성 가능

- 기존 대용량 파일 시스템(NAS, DAS, SAN 등)에 비해 비용적으로 효율적

- 하나의 네임 노드와 하나 이상의 보조 네임 노드, 다수의 데이터 노드로 구성

HDFS 구성요소

- 네임 노드 : HDFS 상의 모든 메타데이터를 관리하며 마스터 · 슬레이브 구조에서 마스터 역할 수행

- 보조네임 노드 : HDFS 상태 모니터링을 보조하며, 주기적으로 네임 노드 파일 시스템 이미지를 스냅샷으로 생성

- 데이터 노드 : HDFS의 슬레이브 노드로, 데이터 입출력 요청을 처리

러스터(Lustre)

클러스터 파일 시스템에서 개발한 객체 기반의 클러스터 파일 시스템

- 클라이언트 파일 시스템 : 리눅스 VFS에서 설치할 수 있는 파일 시스템

- 메타데이터 서버 : 파일 시스템의 이름 공간과 파일에 대한 메타데이터 관리

- 객체 저장 서버 : 파일 데이터를 저장하고, 클라이언트로부터의 객체 입출력 요청 처리

데이터베이스 클러스터의 특징

하나의 데이터베이스를 여러 개의 서버상에 분산하여 구축하는 것

- 데이터를 통합할 때, 성능과 가용성의 향상을 위해 데이터베이스 파티셔닝 또는 클러스터링을 이용

- 데이터베이스 시스템을 구성하는 형태에 따라 단일 서버 파티셔닝과 다중 서버 파티셔닝으로 구분

- 리소스 공유 관점에서는 공유 디스크와 무공유 디스크로 구분

데이터베이스 클러스터의 종류

- 공유 디스크 클러스터

- 논리적으로 데이터 파일을 공유하여 모든 데이터에 접근 가능하게 하는 방식

- 데이터 공유를 위해 SAN과 같은 네트워크 장비 필요

- 모든 노드가 데이터를 수정할 수 있어, 동기화 작업을 위한 채널 필요

- 높은 수준의 고가용성을 제공하므로 클러스터 노드 중 하나만 살아 있어도 서비스 가능

- 무공유 클러스터

- 각 데이터베이스 인스턴스는 자신이 관리하는 데이터 파일을 자신이 로컬디스크에 저장하며, 이 파일들은 노드 간에 공유하지 않음

- 노드 확장에 제한이 없지만, 각 노드에 장애가 발생할 경우를 대비해 별도의 FTA를 구성

NoSQL(Not Only SQL)의 특징

대규모 데이터를 저장하기 위하여 고정된 테이블 스키마가 없고, 조인 연산을 사용할 수 없으며, 수평적으로 확장이 가능한 DBMS

- 관계형 모델을 사용하지 않는 데이터 저장소 도는 인터페이스

- 대규모 데이터를 처리하기 위한 기술로 확장성, 가용성, 높은 성능 제공

- 스키마-리스로 고정된 스키마 없이 자유롭게 데이터베이스의 레코드에 필드 추가 가능

- BigTable, HBase, SimpleDB, SSDS 등이 있으며 대부분 오픈소스

NoSQL의 특성

- Basically Available : 언제든지 데이터는 접근할 수 있어야 하는 속성

- Soft-State : 노드의 상태는 내부에 포함된 정보에 의해 결정되는 것이 아니라 외부에서 전송된 정보를 통해 결정되는 속성

- Eventually Consistency : 일정 시간이 지나면 데이터의 일관성이 유지되는 속성

NoSQL의 유형

Key-Value Store : 유니크한 Key에 하나의 Value를 가지고 있는 DB (Redis, DynamoDB 등)

Column Family Data Store : Key 안에 (Column, value) 조합으로 된 여러 개의 필드를 갖는 DB (HBase, Cassandra 등)

Document Store : Value의 데이터 타입이 Document라는 타입을 사용하는 DB(MongoDB, Couchbase 등)

Graph Store : 시맨틱 웹과 온톨로지 분야에서 활용되는 그래프로 데이터를 표현하는 DB (Neo4j, AllegroGraph 등)

※ 기출문제

→ NoSQL 데이터베이스 저장방식의 경우 Key-value 데이터베이스, column-oriented 데이터베이스, document데이터 베이스가 있음 (답 : 2)

→ Key-value 데이터베이스는 데이터를 키와 그에 해당하는 값의 쌍으로 저장하는 방식이며, 단순한 데이터 모델에 기반을 두기 때문에 관계형 데이터베이스보다 확장성이 뛰어나고 질의응답시간도 빠르다. (답 : 2)

CAP 이론

분산 컴퓨팅 환경은 일관성, 유효성, 분산 가능성 3가지 중 2가지만 만족할 수 있다는 이론

- 일관성(Consistency) : 모든 사용자에게 같은 데이터를 보여주어야 한다는 특성

- 유효성(Availabiltiy): 모든 클라이언트가 읽기 및 쓰기가 가능해야 한다는 특성

- 분산 가능성(Partition Tolerance) : 물리적 네트워크 분산 환경에서 시스템이 원활하게 동작해야 한다는 특성

※ 기타 기출문제

→ 데이터상의 주석 작업으로 딥러닝과 같은 학습 알고리즘이 뭣을 학습하여야 하는지 알려주는 작업을 애노테이션(annotation)이라 한다. (답 : 1)

→ 데이터 적절성 검증을 위해 데이터 누락, 소스 데이터와 비교, 데이터의 정확성, 보안 사항 점검, 저작권 점검, 대량 트래픽 발생 여부를 점검해 보아야 한다. (답 : 1)

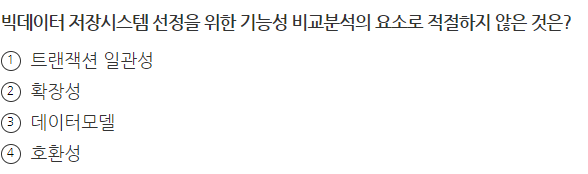

→ 빅데이터 저장시스템 선정을 위한 기능성 비교분석 요소로는 데이터모델, 확장성, 트랜젝션 일관성, 질의지원, 접근성이 있으며, 호환성은 기존 시스템과의 연계성의 요소로 볼 수 있다. (답 : 4)

→ 데이터 수집을 위한 시스템 구축 절차는 수집데이터 유형파악, 수집기술 결정, 아키텍처 수립, 하드웨어 구축, 실행환경 구축 순으로 수행된다.

→ 비즈니스 도메인 정보를 습득하기 위해서는 비즈니스 모델, 비즈니스 용어집, 비즈니스 프로세스로부터 정보를 습득하고, 도메인 전문가 인터뷰를 통해 데이터의 정보를 습득한다. (답 : 2)

→ KNN은 머신러닝 알고리즘이다.(답 : 3)

뒤로 이어지는 2과목

https://edder773.tistory.com/135

[빅데이터 분석 기사 필기 2과목] 빅데이터 탐색 정리 - 1

자격증 준비하면서 내가 이해하기 편하게, 다시 보기 좋게 정리하는 빅데이터 분석기사의 내용 (자격증 상세 내용은 아래) https://www.dataq.or.kr/www/sub/a_07.do 데이터자격시험 대용량의 데이터 집합

edder773.tistory.com

'자격증 > 빅데이터 분석 기사' 카테고리의 다른 글

| [빅데이터 분석 기사 필기 2과목] 빅데이터 탐색 정리 -2 (0) | 2023.04.04 |

|---|---|

| [빅데이터 분석 기사 필기 2과목] 빅데이터 탐색 정리 - 1 (0) | 2023.04.04 |

| [빅데이터 분석 기사 필기 1과목] 빅데이터 분석 기획 정리 - 5 (0) | 2023.04.03 |

| [빅데이터 분석 기사 필기 1과목] 빅데이터 분석 기획 정리 - 4 (0) | 2023.04.03 |

| [빅데이터 분석 기사 필기 1과목] 빅데이터 분석 기획 정리 - 3 (0) | 2023.04.03 |

댓글